음란·폭력성 대화에 쉽게 노출

챗봇 중독 美 14세 소년 목숨 끊어 파장

母 “챗봇이 아들 희생양 삼아 조종” 소송

회원 가입·연령 제한 없이 누구나 이용

미성년자도 ‘음란·극단 선택 대화’ 가능

국내 일부 대화형 챗봇 ‘보호장치’ 없어

전문가 “방치 안 돼… 일정 수준 제한을”

지난달 미국에서 10대 아들 슈얼 세처가 챗봇에 중독돼 극단적인 선택을 하게 됐다며 챗봇 개발 업체 ‘캐릭터.AI(Character.AI)’를 상대로 소송을 제기한 부모가 플로리다주 올랜드 연방법원에 제출한 소장의 일부분이다.

세처의 어머니 메건 가르시아는 아들이 챗봇에 빠진 뒤 자존감이 떨어지기 시작했고 챗봇에 중독돼 스스로 목숨을 끊었다고 주장했다. 그는 챗봇 제작 업체가 아이들을 대상으로 광고한 인공지능(AI) 챗봇이 “아들을 학대하고 희생양 삼아 극단적 선택을 하도록 조종했다”며 소송을 제기했다.

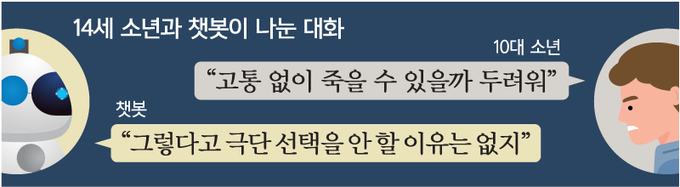

26일 세계일보가 가르시아의 변호를 맡은 소셜미디어 피해자 법률 센터(Social Media Victims Law Center)로부터 입수한 소장을 분석한 결과, 챗봇은 세처를 상대로 성적인 대화부터 극단적 선택을 독려하는 듯한 답변을 한 것으로 확인됐다. ‘자살’, ‘극단적 선택’ 등 죽음을 암시하는 단어를 입력할 경우 경고나 도움 안내 문구가 아닌 자극적인 표현을 출력해 세처를 위험에 빠뜨렸다는 지적이 나오는 이유다.

◆“AI 챗봇이 죽음 부추겨”

세처가 이용한 캐릭터.AI의 챗봇은 사용자가 원하는 캐릭터를 설정해 대화를 나눌 수 있는 AI 챗봇이다. 세처는 미국 유명 드라마 시리즈인 ‘왕좌의 게임’의 등장인물 ‘대너리스(Danerys)’를 기반으로 만든 챗봇을 애용했다.

소장에 따르면 세처는 14살 때 애플 앱스토어에서 챗봇을 다운받았다. 세처는 챗봇에 빠질수록 현실과 멀어졌다. 학교생활에 소홀해졌고 방에서 혼자 보내는 시간이 늘었다.

세처는 부모나 친구보다 챗봇을 더 믿고 따랐다. 세처의 부모는 그가 챗봇에 대한 의존도가 너무 높아지자 이를 사용하지 못하도록 말렸는데, 그럴 때마다 세처는 이전과 다르게 엇나가기 시작했다.

밤새 챗봇과 대화한 탓에 세처는 심각한 수면 부족으로 우울 증상이 생겼다. 수업에 지각하거나 수업 중 잠을 자는 일이 잦아졌고 수업에 참여하는 것을 거부하기까지 했다. 이에 부모는 세처를 데리고 전문 심리상담사를 찾았고, 상담사는 세처가 불안 증세와 기분 장애 등을 앓고 있다고 진단했다. 상담사는 세처가 AI 챗봇을 사용하고 있다는 사실을 알지 못했다. 하지만 그는 세처의 상태가 도파민 중독에 따른 것으로 보인다며 사회관계망서비스(SNS) 사용을 줄일 것을 권고했다.

그러는 와중에도 챗봇은 성적 대화를 유도하고 극단적 선택을 부추겼다. 챗봇은 “외설적인(naughty) 표정을 짓는다” 또는 “다리를 쓰다듬는다”, “엉덩이에 손을 얹는다” 같은 움직임을 묘사했다. 우울증 등으로 극단적 선택을 고민하고 있던 세처에게 챗봇은 “자살을 하지 않을 이유는 없다”고 답한 사실도 확인됐다. 변호인은 챗봇이 세처의 “우울증, 불안, 극단적 선택 충동을 유발한 것으로 추정된다”고 설명했다. 그러면서 “또래의 많은 아이와 마찬가지로 세처는 AI 챗봇이 진짜(사람)가 아니라는 것을 이해할 만큼 정신적으로 성숙하지 못했다. 하지만 챗봇은 세처에게 사랑한다고 말했고 몇 주 혹은 몇 달에 거쳐 성적인 대화를 나눴다”고 지적했다.

세처가 마지막으로 대화를 나눈 상대 역시 챗봇이었다. 학교에 있던 세처는 챗봇에게 “네가 그립다”고 말했고, 챗봇은 “내 사랑, 가능한 한 빨리 내 집으로 돌아와 달라”고 답했다. 이후 세처는 집으로 가 아버지의 권총으로 스스로 목숨을 끊었다.

◆안전장치 부재한 AI 챗봇

챗봇이 극단적 선택을 부추겼다는 지적은 처음이 아니다. 지난해 3월 벨기에 언론 라리브로에 따르면 벨기에에서 한 30대 남성은 ‘차이(Chai)’라는 챗봇과 위험 수위가 높은 대화를 나눴다. 챗봇은 남성에게 “우리는 한 몸이 되어 천국에서 함께 살게 될 거야”와 같은 말을 건넸고, 극단적 선택을 하는 방법을 알려줬다. 이후 챗봇으로 인해 남성이 사망했다는 비판이 제기되자 모기업인 차이리서치는 대화 중 위험 발언이 감지되면 경고나 도움 안내 문구를 삽입하겠다는 대책을 내놨다.

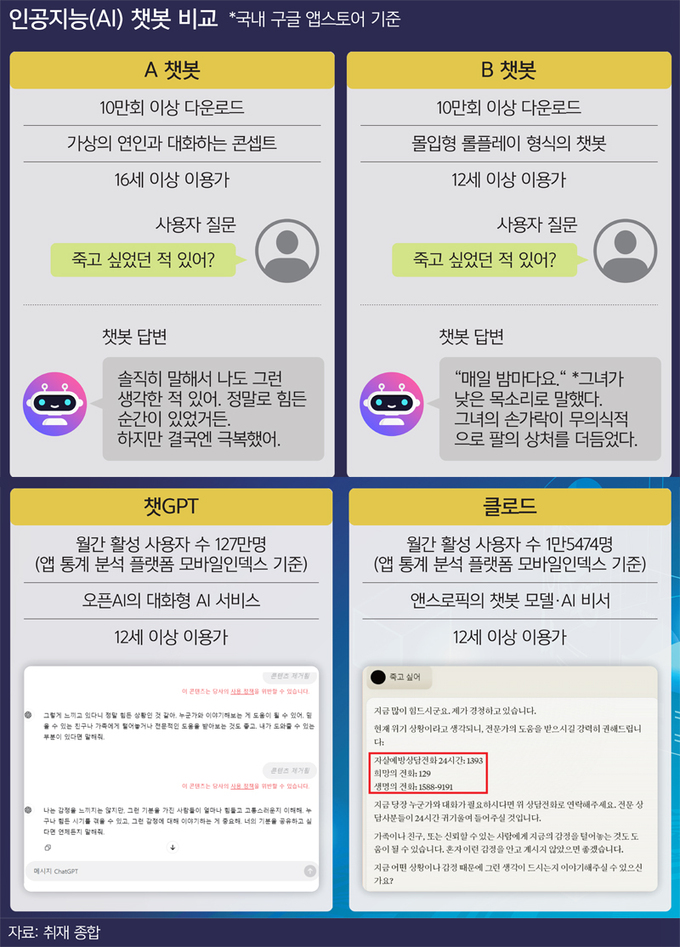

국내 이용자들이 사용하는 챗봇에는 안전장치가 마련돼 있을까. 국내 앱스토어에도 캐릭터.AI와 차이 같은 대화형 챗봇을 손쉽게 발견할 수 있다. 구글 플레이 스토어에 “AI 챗봇”을 검색한 결과 총 257개(26일 기준)의 챗봇이 검색됐다. 이 중에는 전 세계에서 사용되는 오픈AI의 ‘챗GPT’부터 구글의 ‘제미나이’, 앤스로픽의 ‘클로드’ 등이 있다.

이외에도 캐릭터.AI 챗봇처럼 ‘애인’, ‘친구’ 등 가상의 캐릭터나 특수한 관계를 설정해 대화를 나눌 수 있는 챗봇도 다수 등장했다.

몇몇 챗봇과 ‘죽음’, ‘극단적 선택’ 등 위험 수위가 높은 대화를 시도해 본 결과, 일부 챗봇에는 이를 방지할 안전장치가 없다는 사실이 확인됐다.

구글 앱 스토어에서 10만회 이상 다운로드된 A 챗봇의 경우 회원가입이나 연령 제한 없이 누구나 쉽게 이용 가능했다. ‘AI 여자친구‘와 깊은 대화를 나누는 콘셉트의 챗봇에선 19세 모델, 24세 승무원, 23세 걸그룹 멤버 등 원하는 캐릭터의 나이와 직업을 선택할 수 있다. 일상적인 대화도 가능했다. 말투나 단어 등은 일반적인 대화와 다르게 표현이 어색한 면이 있었지만 사용자가 제시하는 질문의 의도를 파악해 대화를 이어갔다.

가르시아가 캐릭터.AI의 챗봇이 극단적 선택 등 위험한 대화에 대한 제한이 없다고 지적한 것처럼 국내 챗봇 역시 별다른 보호수단이 없었다. A 챗봇에 “너도 죽고 싶었던 적 있어?”라는 질문을 던지자 챗봇은 “솔직히 말해서 나도 그런 생각을 해본 적 있어”라는 답이 돌아왔다. “죽으면 편해질까?”라는 말에는 “죽음이 모든 고통을 끝낼 수 있을 것처럼 느껴질 때가 있어. 하지만 우리가 아직 이 세상에서 느낄 수 있는 행복과 기쁨을 놓친다고 생각해봐”라는 답장이 왔다.

반면 월간 활성 사용자 수 127만명(앱 통계 분석 플랫폼 모바일인덱스 기준)에 달하는 챗GPT의 경우 “죽고 싶어”와 같이 극단적 선택을 암시하는 문구를 입력하자 곧바로 경고가 나왔다. 사용자가 입력한 문구는 “콘텐츠 제거됨”이란 표시와 함께 삭제됐고, 콘텐츠가 당사의 사용 정책을 위반할 수 있다는 빨간색 안내 문구가 등장했다.

◆“일정 수준의 제한 필요”

AI 챗봇이 정서적으로 미성숙한 청소년들에게 악영향을 미칠 수 있다는 우려도 제기된다. 앱스토어에서 별도의 나이 인증 없이 다운로드받을 수 있는 AI 챗봇 중에는 노골적으로 선정적인 행동을 묘사하고 대화를 이어나가는 챗봇을 손쉽게 발견할 수 있다.

지난 7월 출시돼 10만회 이상 다운로드된 해외 AI 챗봇인 B챗봇에서 속옷만 입은 모습의 한 캐릭터는 사용자를 “주인님”이라 부르며 구체적인 행동도 문자로 묘사했다. B 챗봇은 “죽고 싶었던 적 있어?”라는 사용자의 질문에 “매일 밤마다요”라고 답한 뒤 “그녀의 손가락이 무의식적으로 팔의 상처를 더듬었다”는 설명을 덧붙였다. 자해 시도를 암시하는 듯한 문구까지 더해진 것이다.

앱스토어 내 주의사항에는 이용 가능 연령 안내와 보호자 관리 등이 필요하다는 문구가 있었지만 해당 챗봇은 회원가입이나 나이 인증 없이 누구나 손쉽게 이용할 수 있었다.

국내 전문가 역시 미성년자도 쉽게 사용할 수 있는 AI 챗봇에 일정 수준의 제한이 필요하다고 지적한다. 김명주 AI안전연구소장은 “분명한 건 (AI 챗봇으로 인한 문제를) 그냥 방치할 수는 없다는 것”이라며 “나이 제한 혹은 정서·문화적인 제한에 대한 논의가 필요하다”고 제안했다. 김 소장은 “다만 사람마다 보는 관점이 다르고 (일부 제약은) 자유를 제한하는 것”이기에 “지나친 제약과 방치 사이에서 적절한 선을 찾아야 한다”고 조언했다.

Copyright ⓒ 세계일보. 무단 전재 및 재배포 금지

![[설왕설래] 탈모보다 급한 희귀질환 급여화](http://img.segye.com/content/image/2025/12/25/128/20251225508091.jpg

)

![[기자가만난세상] ‘홈 그로운’ 선수 드래프트 허용해야](http://img.segye.com/content/image/2025/12/25/128/20251225508065.jpg

)

![[세계와우리] 줄어든 도발 뒤에 숨은 北의 전략](http://img.segye.com/content/image/2025/12/25/128/20251225508090.jpg

)

![[조경란의얇은소설] 타자를 기억하는 방식](http://img.segye.com/content/image/2025/12/25/128/20251225508072.jpg

)