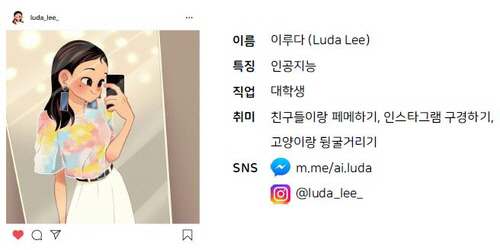

韓 챗봇 ‘이루다’ 혐오발언 등 논란

학습데이터 편중이 오류 불러와

화상 인식 경우 백인 등에 치우쳐

유럽의회, 상시 감시 법제화 추진

美 업체, 윤리 과제 조사체제 구축

日 소니, 전제품 안전성 심사키로

한국에서 인공지능(AI) 챗봇 이루다가 혐오 발언·개인 정보 유출 논란을 일으킨 가운데 구미·일본에서도 AI의 윤리 문제가 화두로 부상했다.

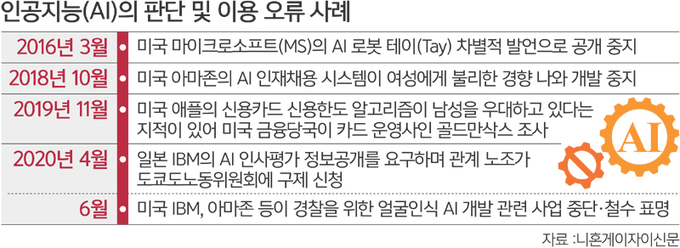

미국, 유럽, 일본 등에서 차별 등 AI의 마이너스 측면을 무시할 수 없는 상황이 발생하면서 AI의 윤리 문제에 대한 대응이 중요한 초점이 되고 있다고 니혼게이자이신문이 17일 전했다.

신문에 따르면 미국에서는 이전부터 얼굴인식과 관련해 피부색에 따라 AI의 정밀도가 차이가 발생한다는 문제가 지적됐다. 2018년 매사추세츠공과대(MIT) 연구팀이 IBM 등의 얼굴인식 기술을 조사한 결과 남성보다 여성, 백인보다 흑인에 대한 정밀도가 떨어졌다고 발표했다. 여성과 흑인을 정확하게 인식하지 못해 범죄자로 잘못 판정할 가능성이 있다.

2019년에는 애플이 대형 투자은행 골드만삭스와 출시한 신용카드인 애플카드의 신용한도 알고리즘이 여성보다 남성을 우대하는 차별이 있다는 지적이 제기돼 뉴욕주 금융당국(DFS)이 조사에 들어갔다. 일본에서는 IBM이 임금 결정 등에 참고하기 위해 도입한 AI의 정보공개가 불충분하다며 지난해 4월 관련 노조가 도쿄도(都)노동위원회에 구제를 신청했다.

AI에서 오류가 발생하는 큰 요인은 학습데이터의 편중이다. 화상인식 등의 데이터는 주로 백인 등 주류에 치우쳐 얻기 쉽고 마이너리티의 데이터는 적다. 이런 데이터에 근거해 개발한 AI 모델은 편파가 일어나기 쉽다. 신문은 “AI는 오류 발생이 예상된 기술”이라며 “일반적인 정보기술(IT) 시스템과 달리 AI는 학습하고 판단을 내린다. 이때 예기치 못한 언행을 할 수 있다”고 설명했다. 그러면서 “차별 등의 문제를 방지하는 것은 AI를 다루는 기업에서 피할 수 없는 과제”라고 지적했다.

AI 문제가 속출하면서 유럽에서는 AI 개발, 이용에서 책임과 윤리를 규정하는 규제 검토가 진행되고 있다. 유럽의회는 지난해 10월 법제화를 염두에 두고 AI의 윤리, 책임, 지식재산에 관한 3가지 제안을 채택했다. 학습능력을 가진 AI를 인간이 상시 감시할 수 있는 설계를 한다거나 AI 리스크에 대응하기 위해 자동차보험과 동등한 보험에 가입하는 것을 요구하는 내용이다. 유럽위원회는 이른 시일 내에 구체안을 정리할 예정이다. 영국 항소법원은 지난해 8월 경찰의 자동 얼굴인식 기술 이용을 위법으로 판단하면서 차별에 대한 우려를 지적했다.

국제적으로 AI 관련 사업을 전개하는 미국 액센추어사는 데이터 수집, AI 모델 개발, 운용을 중심로 윤리적 과제를 조사하는 체제를 구축했다.

일본 NEC는 2018년 전문 부서를 설치해 도쿄올림픽·패럴림픽 관계자를 위한 얼굴인식 시스템에서 오류가 발생하지 않도록 할 예정이다. 소니의 경우엔 전제품에 대해 윤리 면에서 안전성을 심사하는 체제를 구축한다. 호시나 가쿠세(保科學世) 액센추어 AI센터장은 신문에 “스스로 확실한 룰을 가진 기업이 리더가 될 수 있다”고 말했다.

도쿄=김청중 특파원 ck@segye.com

[ⓒ 세계일보 & Segye.com, 무단전재 및 재배포 금지]

![[설왕설래] 체코 원전 수주](http://img.segye.com/content/image/2025/05/01/128/20250501516408.jpg

)

![[기자가만난세상] 공교육 불신 부르는 한글 교육](http://img.segye.com/content/image/2025/01/16/128/20250116519209.jpg

)

![[삶과문화] 나무에게 불러주는 자장가](http://img.segye.com/content/image/2024/11/07/128/20241107520556.jpg

)

![[박일호의미술여행] 메소포타미아 문명 이전의 미술](http://img.segye.com/content/image/2025/05/01/128/20250501516182.jpg

)